Từ một công nghệ giải trí, Deepfake đang bị các tội phạm lừa đảo lợi dụng để chiếm đoạt tài sản, tung tin đồn thất thiệt.

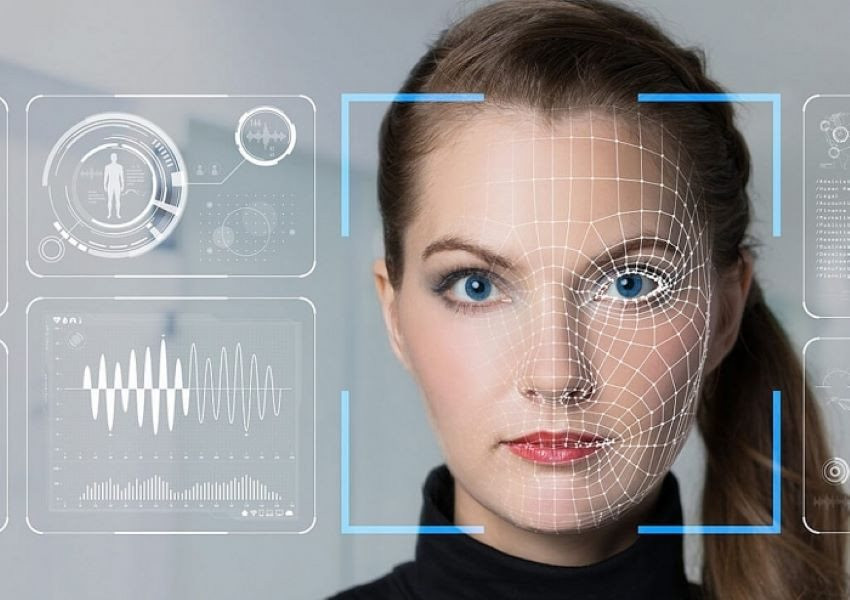

Deepfake là công nghệ được biết đến nhiều nhất với tác dụng tái tạo lại khuôn mặt của người trong video nhờ sử dụng trí tuệ nhân tạo (AI). Ban đầu, công nghệ này được sinh ra cho mục đích giải trí, giúp người dùng lồng khuôn mặt, giọng nói của mình vào các nhân vật yêu thích trên video mà vẫn đảm bảo hoạt động giống như được quay thực tế.

Tuy nhiên, giới tội phạm nhanh chóng lợi dụng ưu điểm đó để tạo ra công cụ giả mạo người khác, giúp chúng thực hiện các vụ lừa đảo hoặc lan truyền tin thất thiệt trên mạng.

Trên thế giới đã có nhiều trường hợp lừa đảo liên quan đến Deepfake được ghi nhận. Mới đây nhất, theo Daily Mail, một gia đình tại Texas (Mỹ) đã mất hàng nghìn USD chuyển cho kẻ gian sau khi chúng sử dụng AI và Deepfake để giả giọng con trai họ thông báo vừa gặp tai nạn xe hơi.

Hoặc trường hợp những bức hình cựu Tổng thống Mỹ Donald Trump bị cảnh sát đưa đi được phát tán trên mạng gần đây thực chất do AI tạo ra. Một số người thậm chí lợi dụng công nghệ Deepfake để bắt đầu tạo ra những video quay cảnh ông Trump bị bắt.

Một nghiên cứu gần đây cho thấy chỉ trong năm 2020, gian lận danh tính do Deepfake tạo ra đã gây thiệt hại cho các tổ chức tài chính khoảng 20 tỷ USD. Trung bình một kẻ lừa đảo thông qua Deepfake để đánh cắp từ 81.000 đến 97.000 USD trước khi vụ lừa đảo bị phanh phui...

Còn tại Việt Nam, các chiêu trò lừa đảo bằng Deepfake cũng đã bắt đầu xuất hiện tại một số thành phố lớn như Hà Nội, TP HCM,... Công an đã ghi nhận nhiều trường hợp bị lừa số tiền lên tới hàng chục triệu đồng.

Kịch bản của những kẻ lừa đảo thường sẽ diễn ra như tìm cách chiếm đoạt tài khoản Zalo, Facebook của người dùng, tiếp đó thu thập hình ảnh (có thể cả giọng nói của nạn nhân từ các video) và dùng Deepfake tạo ra đoạn video mạo danh.

Sau đó kẻ lừa đảo tiến hành nhắn tin mượn tiền những người dùng trong danh sách bạn bè Facebook của nạn nhân, đồng thời thực hiện cuộc gọi video mạo danh, phát video giả mạo để tăng độ tin cậy nhằm lừa đảo thành công hơn.

Thường những cuộc gọi video giả mạo này sẽ rất ngắn với mục đích cho bạn bè hay người thân của nạn nhân nhìn thoáng qua, sau đó tắt đi với lý do sóng điện thoại kém. Mấu chốt của việc lừa đảo này là để nạn nhân tin rằng bạn bè, người thân của mình đang gặp vấn đề và cần giúp đỡ, gửi tiền gấp.

Làm sao để tránh cạm bẫy Deepfake?

Lợi dụng công nghệ Deepfake là một hình thức lừa đảo vô cùng tinh vi. Chính vì vậy, các chuyên gia đã chỉ ra một số biện pháp để giúp người dân đối phó với loại hình tội phạm công nghệ cao này.

Theo đó, nếu nhận được một cuộc gọi yêu cầu chuyển tiền gấp, trước tiên hãy bình tĩnh và xác minh thông tin:

- Chủ động xác thực bằng cách gọi điện thoại trực tiếp hoặc facetime (mặt đối mặt) ít nhất trên 1 phút, sau đó giả vờ đặt ra những câu hỏi cá nhân mà chỉ có bạn và người kia mới biết.

- Kiểm tra kỹ số tài khoản được yêu cầu chuyển tiền. Nếu là tài khoản lạ, tốt nhất là không nên tiến hành giao dịch.

- Nếu cuộc gọi từ người tự xưng là đại diện cho ngân hàng, hãy gác máy và gọi trực tiếp cho ngân hàng để xác nhận cuộc gọi vừa rồi có đúng là ngân hàng thực hiện hay không.

- Các cuộc gọi thoại hay video có chất lượng kém, chập chờn là một yếu tố để bạn nghi ngờ người gọi cũng như tính xác thực của cuộc gọi.

Hãy lưu giữ cẩn thận thông tin cá nhân như số căn cước công dân, địa chỉ nhà riêng, ngày sinh, số điện thoại, tên đệm và thậm chí cả tên của con cái, thú cưng... để tránh bị kẻ lừa đảo lợi dụng.

Deepfake AI – Cơn ác mộng của các thần tượng K-pop

Quốc gia đầu tiên trên thế giới cấm toàn diện nội dung deepfake