Nếu ChatGPT không chạy trên Microsoft Azure mà chạy trên Groq, nó có thể nhanh hơn 13 lần.

Một công ty chip AI đã gây sốt trên Internet, khi hiệu năng và tốc độ của nó đang khiến các mô hình nổi tiếng hiện tại như ChatGPT, Gemini hay Grok (của Elon Musk) như những ông già chậm chạp.

Theo clip trình diễn được đăng tải trên nền tảng X, chỉ trong một vài giây, Groq đã tạo ra câu trả lời dài hàng trăm chữ, kèm theo các nguồn thông tin tham chiếu. Trong một clip demo khác, nhà sáng lập và là CEO công ty, Jonathon Ross đã cho người dẫn chương trình của CNN có thể đối thoại theo thời gian thực với một chatbot AI ở cách xa nửa vòng trái đất, ngay trên chương trình truyền hình trực tiếp.

|

| Bài đăng giới thiệu về groq.com trên X đã thu hút gần 400.000 lượt xem. |

Chỉ trong chưa đến 3 giây, chatbot chạy trên chip AI của Groq đã có thể sản sinh ra một câu trả lời dài với các nguồn thông tin đối chiếu. Thậm chí theo người dùng Matt Shumer, 3/4 thời gian nói trên là tìm kiếm thông tin, chứ không phải để sản sinh ra câu trả lời.

Điều này đặc biệt quan trọng. Mặc dù ChatGPT, Gemini hay nhiều chatbot khác nổi tiếng về khả năng xử lý đa dạng và thông minh của mình, hầu hết các tác vụ của nó đều được chạy trên nền đám mây internet, vì vậy độ trễ và khả năng xử lý khiến chúng không thể xử lý các tác vụ trong thời gian thực. Thế nhưng với bộ xử lý của Groq, tốc độ của chúng trở nên hoàn toàn khác biệt và có thể đáp ứng được việc sử dụng trong thời gian thực.

Điểm mấu chốt là Groq tạo ra chip AI được gọi là các bộ xử lý ngôn ngữ, các LPU (Language Processing Unit), và tuyên bố chúng nhanh hơn hẳn các GPU (Graphics Processing Unit) của Nvidia. Hiện tại các GPU của Nvidia đang được xem là tiêu chuẩn hàng đầu thế giới để chạy các mô hình AI, nhưng kết quả ban đầu cho thấy các LPU của Groq có thể đánh bại chúng về tốc độ.

Khác với các mô hình AI khác, nó hoạt động như một "inference engine" (engine suy luận) giúp các chatbot này chạy cực kỳ nhanh, chứ không thay thế hoàn toàn chúng. Trên trang web của Groq, bạn có thể thử nghiệm các chatbot khác nhau và xem chúng chạy nhanh như thế nào khi sử dụng LPU của Groq.

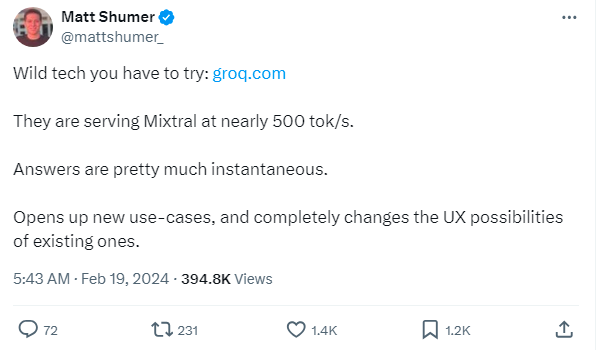

Theo một thử nghiệm độc lập mới được công bố gần đây, Groq tạo ra 247 token/giây so với chỉ 18 token/giây của Microsoft - vốn đang chạy trên các GPU của Nvidia. Điều này có nghĩa ChatGPT có thể chạy nhanh hơn 13 lần nếu sử dụng chip của Groq.

|

| Đo lường khả năng sản sinh token AI trên mỗi giây giữa các nền tảng đám mây AI - Groq cho tốc độ nhanh hơn 13 lần so với Microsoft |

Bước nhảy vọt về tốc độ này sẽ khiến các chatbot AI như ChatGPT, Gemini trở nên hữu ích hơn. Hạn chế hiện tại của các chatbot AI là chúng không thể theo kịp tốc độ nói của con người trong thời gian thực, khiến cho các cuộc trò chuyện đôi khi có cảm giác giống như robot.

Điều này cũng là lý do tại sao nhiều hãng công nghệ còn tìm cách tích hợp các chip AI chuyên dụng vào bộ xử lý smartphone – như Galaxy S24 của Samsung và Pixel 8 của Google – để có thể thực hiện các tác vụ AI tạo sinh ngay trên thiết bị thay vì để các nền tảng đám mây xử lý chúng.

Trong buổi giới thiệu Gemini, Google còn bị cáo buộc giả mạo bản demo của chatbot này để khiến nó trông như thể có thể đối thoại với người dùng đa phương thức theo thời gian thực, trong khi thực tế thì không phải vậy. Nhưng với tốc độ vượt trội của Groq, những video như vậy có thể trở thành hiện thực.

Dù Groq đang nhận được rất nhiều sự chú ý nhờ tốc độ vượt trội của nó, khả năng mở rộng của chip AI này so với các GPU của Nvidia hoặc TPU của Google vẫn là một dấu hỏi. Các bộ xử lý do Nvidia và Google đã trở thành tiêu chuẩn của ngành AI nhờ tên tuổi và kinh nghiệm hoạt động lâu năm. Một công ty chip AI mới nổi dù thu hút được sự chú ý từ công chúng vẫn sẽ cần một thời gian dài nữa để có thể kiểm chứng được các cam kết của mình.

Tuy nhiên, điều đó có thể đến sớm hơn mong đợi khi cơn khát chip AI đang trở thành tiêu điểm trên toàn cầu, không chỉ về nguồn cung mà cả về công nghệ chip. Một trong những nỗ lực mới đây nhất để bắt kịp nhu cầu về chip AI đến từ CEO OpenAI, Sam Altman, khi ông đang tìm cách huy động hơn 7.000 tỷ USD để gia tăng sản lượng chip AI trên toàn cầu, thay vì lệ thuộc hoàn toàn vào Nvidia như hiện tại.

Jonathan Ross - startup Groq, người đứng sau công nghệ Tensor Streaming Processor (TSP) - cấu trúc chip và cũng là cách thức thực hiện tính toán mới.

|

| Jonathan Ross - Người sáng lập Groq |

Công ty khởi nghiệp có trụ sở chính tại Mountain View này được thành lập vào năm 2016 bởi Jonathan Ross, người trước đây đã khởi động dự án cho Bộ xử lý Tensor (TPU) quan trọng hiện nay tại Google. TPU được thiết kế dành riêng cho TensorFlow và hiện gần như là nền tảng kỹ thuật cho tất cả các dịch vụ của Google sử dụng công nghệ máy học.

Trước khi thành lập Groq, Ross là đồng sáng lập bộ phận chip AI của Google, chịu trách nhiệm phát triển các chip tiên tiến để huấn luyện các mô hình AI. Với các chip LPU, Ross cho biết Groq đã vượt qua hai điểm nghẽn của các mô hình ngôn ngữ lớn (LLM) mà GPU và CPU thường gặp phải: mật độ tính toán và băng thông bộ nhớ.

Kể từ khi thành lập vào năm 2016, Ross không chỉ đào tạo được nhiều nhân tài tại các địa điểm ở Hoa Kỳ, Canada và Vương quốc Anh. Nếu muốn thử xem LPU hoạt động tốt như thế nào, bạn có thể làm như vậy trên trang web Groq. LLM nguồn mở từ Mistral (Mixtral 8X7B) và Meta (Lama 7B) được tích hợp ở đó để thể hiện hiệu suất của Groq.

Năm 2020, công ty này đã công bố thành tựu đáng kinh ngạc: bằng cấu trúc TSP, chip của họ có thể thực hiện được tới 1 peta tác vụ trong một giây, tức là 1.000.000.000.000.000 tác vụ chỉ trong một cái chớp mắt dài một giây.

Trước đó, Groq thông báo đã đạt thỏa thuận với công ty điện tử Samsung của Hàn Quốc về sản xuất dòng chip mới.

Trong thông báo, Groq cho biết sẽ phối hợp với nhóm thiết kế Samsung Foundry và sản xuất chip theo quy trình SF4X (sản xuất chip 4nm) - công nghệ nền tảng FinFET 4nm tiên tiến của Samsung.

Dòng chip này dự kiến được đưa vào sản xuất tại nhà máy mới của Samsung tại thành phố Taylor, bang Texas (Mỹ) vào năm 2025.

>> Cổ phiếu SoftBank tăng vọt nhờ dự án chip AI trị giá 100 tỷ USD